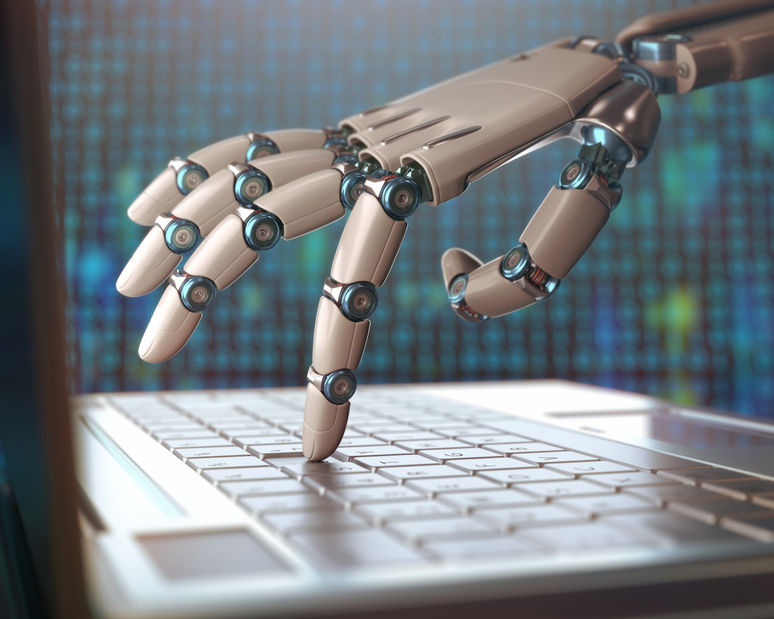

時至春季,人工智能的春天也來了。

從去年 AlphaGo 與李世石的人機大戰之后,人工智能瞬間成為科技行業最為耀眼的明星。除了國內外的巨頭動作頻繁,該領域的創業公司也如雨后春筍般生長起來。而這背后,自然離不開讓機器學會思考的造物主們。本文,我們就來認識一些將人工智能夢想變成現實的功臣們。

阿蘭⋅圖靈

二戰時阿蘭⋅圖靈在布萊切利公園擔任解碼專家,于 1940 年創造出可以破譯德軍密報的機器 Bombe,為盟軍的勝利立下了汗馬功勞。戰后,他任職于泰丁頓國家物理研究所,開始從事“自動計算機”的邏輯設計和具體研制工作。1946 年,圖靈發表論文闡述存儲程序計算機的設計,因此被稱為計算機之父。

基于計算機,他還思考怎么去創造一個思考的機器(Thinking Machine)。他說:“要建造一個智能的機器的話,可能最好的方法就是用錢買得到的最好的感知器來組建它,并教會它使用英文。”

圖靈并沒有建立起人工智能這個領域,但是他帶來了最初的一些重要的思想元素:我們要做一個會思考的機器,里面就需要包括:視覺、語言。另外,圖靈還提出著名的“圖靈測試”,指出如果第三者無法辨別人類與人工智能機器反應的差別,則可以論斷該機器具備人工智能。“圖靈的成就不得地讓我們聯想,是否等到人類滅亡之后會留下機器人來統治這個世界。”互聯網之父文特·瑟夫如此評論。正是圖靈開啟了人工智能研究的先河。如今,由美國計算機協會(The Association for Computing Machinery)設立圖靈獎為其最高獎項,以表彰圖靈在計算機以及人工智能領域的特殊貢獻。

Terry Winograd

Terry 是人工智能界,第一代把圖靈的思想付諸實踐的人,他也是現在在世的計算機界最偉大的科學家之一。Terry 不光在人工智能領域做了最重要的工作,而且他后來轉行去做人機交互,也把這個領域重新帶動了起來。

在 Terry 看來,要實現人工智能,需要有這 3 個要素:語法,語義和推理。他說一個人,或者一個機器,要去理解世界,需要去感知。感知以后,需要做的第一件事是對這個世界的結構進行理解,這叫語法的理解(Syntax Understanding)。Terry 說,機器能夠理解語法以后,接下去需要做的就是理解語義(Semantics)。語義就是指含義,語言有語言的含義,視覺有物體、有動作,有視覺的含義。最后,當我們把語法和語義解決以后,智能的機器或者是人主要解決的問題就是統計推理(Inference)這個過程。1970 年,Terry Winograd 教授在麻省理工學院人工智能實驗室創建了 SHRDLU(積木世界),其被譽為微世界程序的最高成就,它能用普通的英語句子與人交流,還能作出決策并執行操作。可以說它既是自然人展示自己如何借助計算機實現自然語言理解的一個經典示例,也是怎樣應用計算機有效進行自然語言處理的一個里程碑。

Geffory Hinton

人類大腦有數十億個神經細胞,它們之間通過神經突觸相互影響,形成極其復雜的相互聯系。然而科學家們并不能解釋這些具體的影響和聯系。神經到底是如何進行學習以及計算的,對于 Hinton,這些正是他所關心的問題。他不知道所有的答案,但在他的努力之下已經取得了進展。

Geoffrey Hinton 被尊稱為“神經網絡之父”,將 Back Propagation(反向傳播)算法應用到神經網絡與深度學習,還提出了“Dark Knowledge”概念。他將神經網絡帶入到研究與應用的熱潮,這些人工神經網絡可以收集信息,也可以對其做出反應。它們能對事物的外形和聲音做出解釋。它們對語言的理解也在進步。它們可以自行學習與工作,而不需要人為提示或者參與控制。這些正是它們與傳統的學習機器的區別。隨著時間的推移,計算機能力的發展,神經網絡也更加快速,靈活,高效,得到了很好的擴展。

據了解,早在 80 年代初期,當 Hinton 和他的同事們剛開始這項研究時,那時的電腦還不夠快,不足以處理有關神經網絡的這些龐大的數據,他們取得的成就是有限的。而當時 AI 普遍的研究方向也與他們相反,都在試圖尋找捷徑,直接模擬出行為,而不是試圖通過模仿大腦的運作來實現。在這樣艱難的環境下,只有 Hinton 和他的同事堅持了下來,而事實則證明他們是對的。

Geoffrey Hinton 于 2006 年在《Science》上發表的論文首次提出深度學習的主要觀點。從 2012 年取得 ImageNet 競賽的標志性事件之后,深度學習不斷取得一系列的重大進展,解決了人工智能界的盡最大努力很多年仍沒有進展的問題,除了在圖像識別、語音識別等領域打破了紀錄,還在其他的領域擊敗了其他機器學習技術,包括預測潛在的藥物分子的活性、分析粒子加速器數據、重建大腦回路、預測非編碼 DNA 突變對基因表達和疾病的影響。更令人驚訝的是,深度學習在自然語言理解的各項任務中也有非常可喜的成果,特別是主題分類、情感分析、自動問答和語言翻譯。

可以說,正是 Geoffrey Hinton 將“深度學習”從邊緣課題變成了谷歌等互聯網巨頭仰賴的核心技術。

Yann LeCun

Yann LeCun,Geoffrey Hinton 的博士后學生,也是將 CNNs 應用最成功的人(CNNs,是一種深度的監督學習下的機器學習模型)。目前感興趣的研究領域包括人工智能、機器學習、計算機感知、機器人和計算神經科學。他最出名的是對深度學習和神經網絡的貢獻,特別是廣泛用于計算機視覺和語音識別應用的 CNN(卷積神經網絡),他第一個把 BP 算法用在 CNN 上并且完善 CNN 使得它可以在真實場景中得以應用,并在這些主題以及手寫字體識別、圖像壓縮和人工智能硬件等主題上發表過 190 多份論文。

LeCun 使 CNN 成為目前人工智能領域最有用的模型。在谷歌,卷積神經網絡幫助他們在安卓手機上開發語音識別系統;而百度則可以利用它開發全新的視覺搜索引擎。

Yann LeCun 是紐約大學終身教授,現任 Facebook 人工智能實驗室負責人。LeCun 位列新澤西州的發明家名人堂,并獲得 2014 年 IEEE 神經網絡先鋒獎、2015 年 IEEE PAMI 杰出研究獎、2016 年 Lovie 終身成就獎和來自墨西哥 IPN 的名譽博士學位。

Yoshua Bengio

Yoshua Bengio 教授是機器學習大神之一,尤其是在深度學習這個領域。他連同 Geoff Hinton 以及 Yann LeCun 教授,締造了 2006 年開始的深度學習復興。

其他方面,Bengio 的《a neural probabilistic language model》這篇論文開創了神經網絡做 language model 的先河,里面的思路影響、啟發了之后的很多基于神經網絡做 nlp(自然語音處理) 的文章。

Bengio 博士后的導師 Jordan 曾提到:“到目前為止,在更高級的自然語言處理任務中,深度學習并未像在語音識別、物體識別等任務上做到的那樣,顯著降低錯誤率。”所以在 Hinton 提出深度學習概念激活了整個領域、lecun 發表了卷積神經網絡 (CNN) 這樣的階段性突破成果的前提下,Bengio 對自然語音處理難題的貢獻是非常有意義的。

Jürgen Schmidhuber

1997 年,Schmidhuber 博士和他的同事發表了一篇技術論文,后來證明這篇論文對最近的視覺和語音上的快速進展起到了關鍵作用。這個方法被稱長短期記憶,簡稱為 LSTM。這個方法在剛引進時沒有得到廣泛的理解。它主要提供了一種記憶形式,或者說是一種神經網絡的環境。

就像人類不會每次都從頭學起一樣,神經網絡的機制中存在循環和記憶的機制,每個輸入的單詞和觀察到的像素都會被其理解。長短時記憶(LSTM)的出現讓這種系統的表現得到了很大的提升,輸出結果瞬間變得準確。

去年,谷歌的研究人員在這一方面的研究得到發表,他們使用 LSTM 減少了 49% 的語音識別錯誤,這是一個飛躍性進步。